Die Einführung von ChatGPT im November 2022 markierte einen Wendepunkt in der Geschichte der künstlichen Intelligenz. Innerhalb weniger Monate erreichte diese Technologie über 100 Millionen Nutzer und wurde damit zur am schnellsten wachsenden Verbraucheranwendung aller Zeiten. Mit der Veröffentlichung von GPT-4 im März 2023 und weiteren Verbesserungen seither haben große Sprachmodelle (Large Language Models, LLMs) einen noch größeren Sprung in ihrer Leistungsfähigkeit gemacht. In diesem Artikel untersuchen wir die Entwicklung dieser bahnbrechenden Technologie, ihre Funktionsweise, praktische Anwendungen und die Auswirkungen auf Gesellschaft und Wirtschaft.

1. Die Evolution der GPT-Modelle

Die Geschichte der GPT-Modelle (Generative Pre-trained Transformer) ist eine Geschichte rasanter Fortschritte. Jede neue Generation hat signifikante Verbesserungen in Bezug auf Größe, Fähigkeiten und Verständnis gebracht.

Von GPT-1 zu GPT-3

Der Weg begann mit GPT-1, das 2018 von OpenAI vorgestellt wurde und 117 Millionen Parameter umfasste. GPT-2 folgte 2019 mit 1,5 Milliarden Parametern und zeigte bereits beeindruckende Fähigkeiten zur Texterstellung, die OpenAI zunächst dazu veranlassten, das vollständige Modell aus Bedenken hinsichtlich möglichen Missbrauchs nicht sofort zu veröffentlichen.

Der wirkliche Durchbruch kam 2020 mit GPT-3, das mit seinen 175 Milliarden Parametern einen gewaltigen Sprung darstellte. Dieses Modell zeigte erstmals die Fähigkeit, komplexe Aufgaben mit minimaler Anleitung zu lösen – ein Konzept, das als "few-shot learning" bekannt wurde.

ChatGPT und die Demokratisierung von KI

Ende 2022 führte OpenAI ChatGPT ein, eine benutzerfreundliche Schnittstelle zu einer optimierten Version von GPT-3.5. Im Gegensatz zu früheren Modellen, die hauptsächlich von Entwicklern und Forschern genutzt wurden, machte ChatGPT fortschrittliche KI für jedermann zugänglich. Die intuitive Chatoberfläche und die Fähigkeit, menschenähnliche Gespräche zu führen, lösten eine beispiellose Welle der Adoption aus.

GPT-4: Ein multimodaler Durchbruch

Im März 2023 stellte OpenAI GPT-4 vor, das einen weiteren bedeutenden Fortschritt darstellte. Obwohl OpenAI die genaue Größe nicht offengelegt hat, zeigt GPT-4 deutlich verbesserte Fähigkeiten in Bezug auf Genauigkeit, Nuancenverständnis und Reasoning. Besonders bemerkenswert ist die multimodale Fähigkeit von GPT-4, sowohl Text als auch Bilder zu verarbeiten und zu verstehen.

Die neuesten Iterationen von GPT-4 haben weitere Verbesserungen gebracht, darunter aktuelleres Wissen durch regelmäßigere Updates, bessere Kontrolle über den Ausgabestil und Ton sowie erweiterte Werkzeuge und Plugins, die das Modell mit externen Datenquellen und Funktionen verbinden.

Die Entwicklung der GPT-Modelle von 2018 bis heute

2. Wie funktionieren moderne Sprachmodelle?

Um die Bedeutung von ChatGPT und GPT-4 zu verstehen, ist es hilfreich, einen Blick auf die grundlegende Technologie zu werfen, die diese Modelle antreibt.

Transformer-Architektur

Die GPT-Modelle basieren auf der Transformer-Architektur, die 2017 von Google-Forschern im Paper "Attention is All You Need" vorgestellt wurde. Im Gegensatz zu früheren Ansätzen wie rekurrenten neuronalen Netzen (RNNs) verwenden Transformer einen Mechanismus namens "Self-Attention", der es dem Modell ermöglicht, die Beziehungen zwischen allen Wörtern in einem Text gleichzeitig zu erfassen, anstatt sie sequentiell zu verarbeiten.

Diese Architektur erlaubt ein tieferes Verständnis von Kontext und Bedeutung und skaliert effizienter auf große Datensätze und Modellgrößen.

Vortraining und Feinabstimmung

Der Trainingsprozess für Modelle wie GPT-4 besteht aus zwei Hauptphasen:

- Vortraining: Das Modell wird mit enormen Mengen an Textdaten aus dem Internet trainiert, um Muster, Grammatik, Fakten und eine grundlegende Weltkenntnis zu erlernen. Während dieser Phase lernt das Modell, das nächste Wort in einer Sequenz vorherzusagen.

- Feinabstimmung: Nach dem Vortraining wird das Modell mit Techniken wie Reinforcement Learning from Human Feedback (RLHF) weiter optimiert. Dabei geben menschliche Bewerter Feedback zu den Modellausgaben, was hilft, das Modell an menschliche Präferenzen anzupassen und problematische Verhaltensweisen zu reduzieren.

Emergente Fähigkeiten

Eine der faszinierendsten Eigenschaften großer Sprachmodelle ist das Auftreten emergenter Fähigkeiten – Fähigkeiten, die bei kleineren Modellen nicht vorhanden sind, aber ab einer bestimmten Größe oder Komplexität erscheinen. Beispiele dafür sind komplexes Reasoning, das Lösen mathematischer Probleme oder das Verstehen von Nuancen in menschlicher Kommunikation.

Diese emergenten Eigenschaften haben Forscher überrascht und deuten darauf hin, dass weitere Skalierung zu noch unentdeckten Fähigkeiten führen könnte.

— Dr. Julia Schmidt, KI-Forscherin"Die bemerkenswerteste Eigenschaft von Systemen wie GPT-4 ist nicht, was sie können, sondern wie sie es können – ohne explizit für diese Aufgaben programmiert worden zu sein."

3. Praktische Anwendungen in verschiedenen Branchen

ChatGPT, GPT-4 und ähnliche Sprachmodelle finden bereits Anwendung in zahlreichen Bereichen und transformieren Arbeitsweisen in verschiedenen Branchen.

Inhaltserstellung und Kreativität

Im Bereich der Inhaltserstellung haben Sprachmodelle die Art und Weise, wie Texte, Marketing-Materialien, Skripte und kreative Werke entstehen, grundlegend verändert. Sie können:

- Erste Entwürfe für Artikel, Blogbeiträge oder Berichte erstellen

- Kreative Schreibprozesse unterstützen, von Dichtung bis zu Drehbüchern

- Mehrsprachige Inhalte generieren und bei Übersetzungen helfen

- Marketing-Copy optimieren und verschiedene Tonalitäten anbieten

Dabei fungieren diese Modelle weniger als Ersatz für menschliche Kreativität, sondern vielmehr als Kollaborateure, die Ideen liefern, Schreibblockaden überwinden helfen und Routineaufgaben übernehmen.

Bildung und Forschung

Im Bildungsbereich bieten Sprachmodelle neue Möglichkeiten für personalisiertes Lernen und Unterstützung:

- Tutoring und Erklärung komplexer Konzepte auf unterschiedlichen Verständnisebenen

- Erstellung von Lernmaterialien und Übungen

- Hilfe bei Recherchen und Zusammenfassungen von Fachliteratur

- Unterstützung beim Erlernen neuer Sprachen

In der Forschung helfen diese Modelle bei der Literaturrecherche, der Hypothesenbildung und sogar bei der Entdeckung neuer Zusammenhänge in wissenschaftlichen Daten.

Programmierung und Softwareentwicklung

Für Entwickler sind Sprachmodelle zu unschätzbaren Assistenten geworden:

- Code-Generierung und -Vervollständigung

- Debugging und Fehlersuche

- Erklärung komplexer Codebasen

- Konvertierung zwischen Programmiersprachen

Tools wie GitHub Copilot, das auf GPT-Technologie basiert, haben bereits gezeigt, wie KI den Entwicklungsprozess beschleunigen und die Produktivität steigern kann.

Kundenservice und Unternehmenskommunikation

Im Geschäftskontext revolutionieren Sprachmodelle die Kommunikation mit Kunden und innerhalb von Organisationen:

- Intelligente Chatbots, die komplexe Kundenanfragen bearbeiten können

- Automatisierte E-Mail-Beantwortung und Kommunikationsunterstützung

- Erstellung von Berichten, Präsentationen und Dokumentationen

- Analyse von Kundenfeedback und Stimmungsanalyse

Die Fähigkeit dieser Modelle, natürliche Sprache zu verstehen und zu generieren, macht sie besonders wertvoll für die Verbesserung der Kundenerfahrung.

Gesundheitswesen

Im Gesundheitssektor unterstützen Sprachmodelle bei verschiedenen Aufgaben:

- Medizinische Dokumentation und Zusammenfassung von Patientenakten

- Unterstützung bei Diagnosen und Behandlungsoptionen

- Patientenaufklärung und -beratung

- Beschleunigung der medizinischen Forschung

Dabei ist wichtig zu betonen, dass diese Modelle als Unterstützung für medizinisches Fachpersonal dienen und nicht als Ersatz für professionelle medizinische Beratung.

Schlüsselanwendungen von GPT-Modellen

- Inhaltserstellung: Texterstellung, kreatives Schreiben, Übersetzungen

- Bildung: Tutoring, Erklärungen, Lernmaterialien

- Programmierung: Code-Generierung, Debugging, Dokumentation

- Geschäft: Kundenservice, Berichterstellung, Datenanalyse

- Gesundheit: Dokumentation, Forschungsunterstützung, Patientenberatung

4. Gesellschaftliche Auswirkungen und Herausforderungen

Die rasante Entwicklung und Verbreitung fortschrittlicher Sprachmodelle bringt neben den vielen Vorteilen auch erhebliche gesellschaftliche Herausforderungen mit sich.

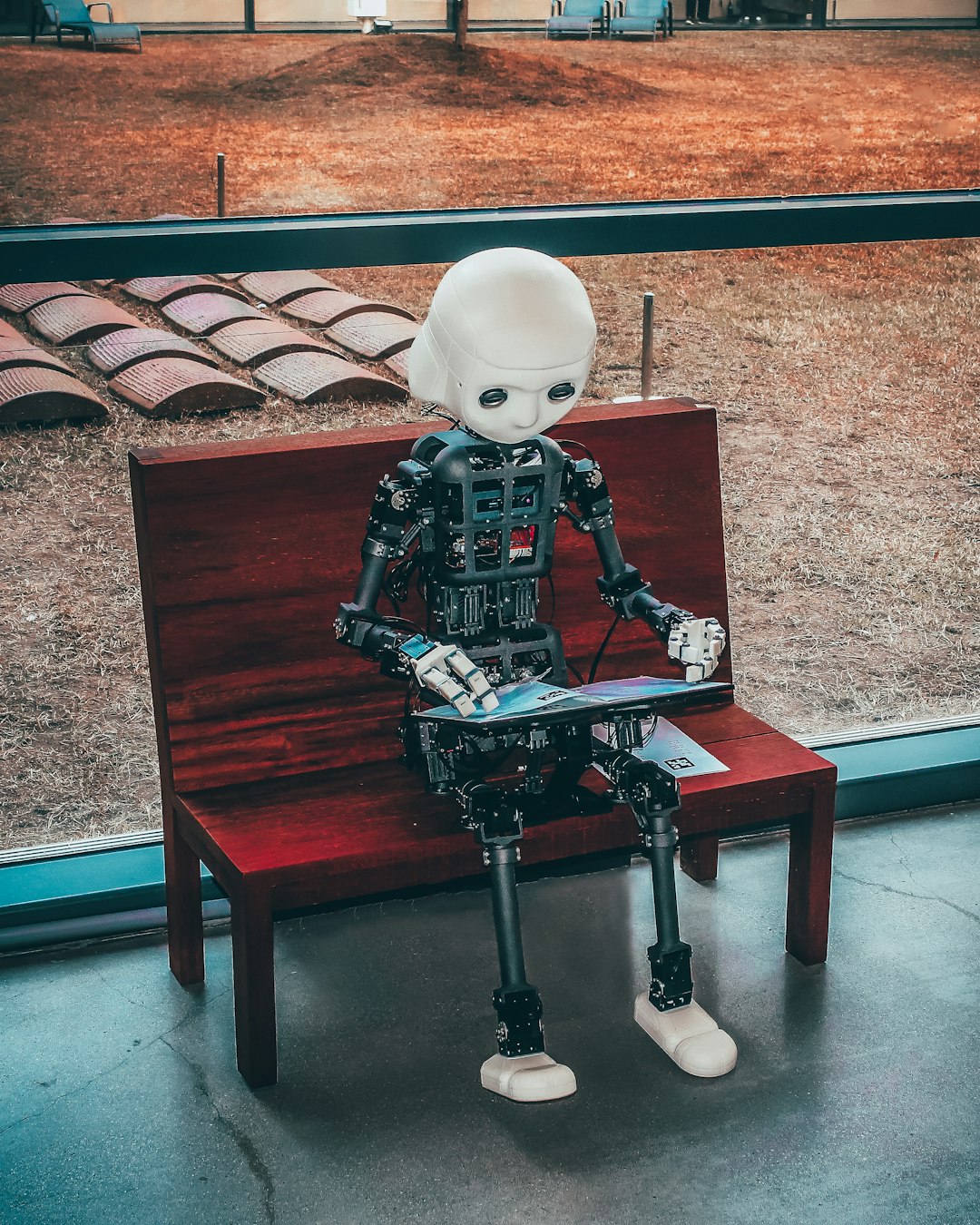

Arbeitsmarktveränderungen

Eine der meistdiskutierten Auswirkungen ist der potenzielle Einfluss auf den Arbeitsmarkt. Während KI-Technologien wie GPT-4 bestimmte Aufgaben automatisieren können, schaffen sie gleichzeitig neue Rollen und verändern bestehende Berufsbilder:

- Automatisierung von Routineaufgaben in Bereichen wie Content-Erstellung, Kundendienst und Datenanalyse

- Entstehung neuer Rollen wie Prompt Engineers, KI-Trainer und KI-Ethik-Spezialisten

- Transformation bestehender Berufe, wobei der Fokus auf höherwertige, kreative und zwischenmenschliche Aspekte der Arbeit gelenkt wird

Die Herausforderung besteht darin, diese Übergänge so zu gestalten, dass Arbeitnehmer unterstützt werden und die Vorteile der Technologie breit verteilt sind.

Ethische Bedenken und Risiken

Der Einsatz fortschrittlicher KI-Modelle wirft wichtige ethische Fragen auf:

- Bias und Fairness: KI-Systeme können bestehende Vorurteile und Ungleichheiten in den Trainingsdaten reproduzieren oder verstärken

- Desinformation: Die Fähigkeit, überzeugende und realistische Inhalte zu generieren, kann zur Verbreitung von Falschinformationen oder Deep Fakes missbraucht werden

- Datenschutz: Die Verarbeitung sensibler Eingaben und die Speicherung von Daten werfen Fragen zum Datenschutz auf

- Transparenz: Die "Black Box"-Natur dieser Modelle macht es schwierig zu verstehen, wie sie zu bestimmten Outputs kommen

Diese Herausforderungen erfordern einen verantwortungsvollen Ansatz bei der Entwicklung und dem Einsatz von KI-Systemen, einschließlich robuster Sicherheitsmaßnahmen, transparenter Kommunikation und kontinuierlicher Überwachung.

Bildung und digitale Kompetenz

Die Integration von KI-Tools wie ChatGPT in Bildungsumgebungen stellt sowohl Chancen als auch Herausforderungen dar:

- Neugestaltung von Bildungsansätzen, wobei der Schwerpunkt von der Informationsmemorisierung auf kritisches Denken, Kreativität und Problemlösung verlagert wird

- Notwendigkeit der Anpassung von Bewertungsmethoden, um den Einsatz von KI-Tools zu berücksichtigen

- Förderung der "KI-Kompetenz" als wesentliche Fähigkeit, um KI-Tools effektiv, ethisch und kritisch zu nutzen

Bildungseinrichtungen und Pädagogen stehen vor der Aufgabe, KI sinnvoll in Lernumgebungen zu integrieren und gleichzeitig sicherzustellen, dass grundlegende Fähigkeiten und kritisches Denken gefördert werden.

5. Die Zukunft der Sprachmodelle

Wohin entwickeln sich Sprachmodelle wie GPT in den kommenden Jahren? Hier sind einige vielversprechende Trends und Entwicklungen:

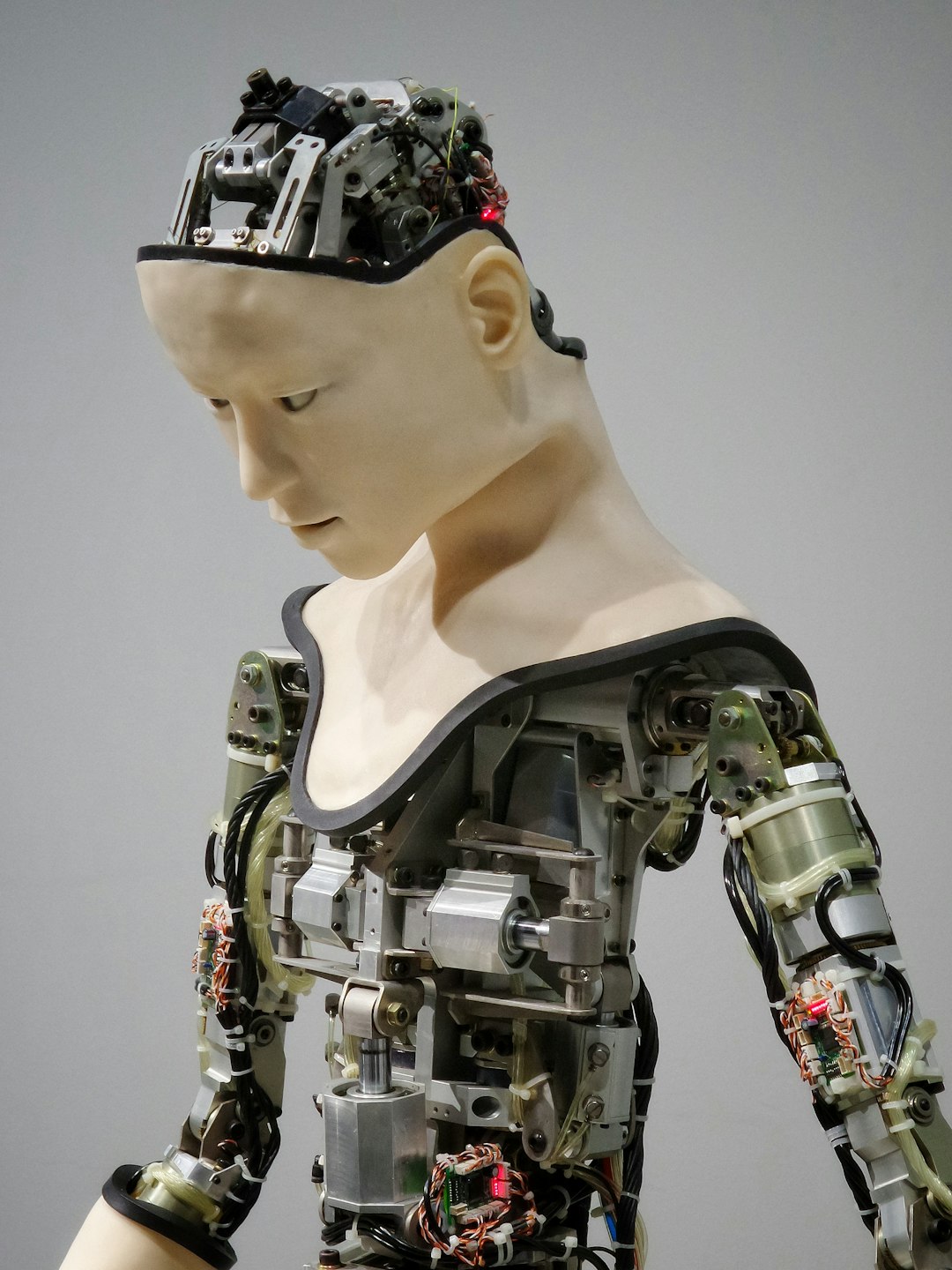

Multimodale Integration

Die Zukunft gehört multimodalen Systemen, die verschiedene Arten von Daten verstehen und verarbeiten können:

- Integration von Text, Bild, Audio und Video in einheitliche KI-Modelle

- Verbesserte Fähigkeit, kontextübergreifend zu verstehen und zu kommunizieren

- Natürlichere und intuitivere Mensch-Computer-Interaktion

GPT-4 mit seiner Text- und Bildverarbeitungsfähigkeit ist erst der Anfang dieser Entwicklung.

Spezialisierung und Anpassung

Während große allgemeine Modelle wie GPT-4 beeindruckende Fähigkeiten haben, entwickelt sich der Trend zu spezialisierten Modellen für bestimmte Domänen und Anwendungen:

- Domänenspezifische Modelle für Bereiche wie Medizin, Recht oder Wissenschaft

- Personalisierte Modelle, die auf individuelle Bedürfnisse, Vorlieben und Arbeitsstile zugeschnitten sind

- Effizientere, kleinere Modelle, die auf spezifischen Geräten laufen können

Diese Spezialisierung wird die Genauigkeit und Nützlichkeit in spezifischen Kontexten verbessern.

Verbesserte Reasoning-Fähigkeiten

Ein Schwerpunkt der Forschung liegt auf der Verbesserung der Reasoning- und Problemlösungsfähigkeiten von Sprachmodellen:

- Integrierte Tools und externe Rechenkapazitäten für komplexere Aufgaben

- Besseres langfristiges Gedächtnis und Kontextverständnis

- Fortschritte im "Chain-of-Thought"-Reasoning und logischen Denken

Diese Verbesserungen werden KI-Systeme befähigen, komplexere Probleme zu lösen und fundiertere Entscheidungen zu treffen.

Verantwortungsvolle KI und Governance

Mit zunehmender Leistungsfähigkeit wird der verantwortungsvolle Umgang mit KI immer wichtiger:

- Robustere Sicherheits- und Alignment-Techniken, um sicherzustellen, dass KI-Systeme menschliche Werte respektieren

- Transparente und erklärbare KI, die Entscheidungen nachvollziehbar macht

- Internationale Zusammenarbeit bei der Governance und Regulierung von KI

Die Herausforderung besteht darin, Innovation zu fördern und gleichzeitig Risiken zu minimieren.

Fazit: Eine neue Ära der Mensch-KI-Zusammenarbeit

ChatGPT, GPT-4 und ähnliche Sprachmodelle markieren einen bedeutenden Wendepunkt in der Entwicklung künstlicher Intelligenz. Sie haben KI demokratisiert und für Millionen von Menschen zugänglich gemacht, was zu einer Welle von Innovationen und neuen Anwendungen geführt hat.

Während wir die Vorteile dieser Technologien nutzen, ist es wichtig, einen ausgewogenen Ansatz zu verfolgen, der Innovation fördert und gleichzeitig potenzielle Risiken adressiert. Die effektivsten Implementierungen werden wahrscheinlich jene sein, die menschliche und künstliche Intelligenz kombinieren, wobei jede ihre einzigartigen Stärken einbringt.

Wir stehen erst am Anfang dieser Reise. Die kommenden Jahre werden zweifellos weitere bahnbrechende Entwicklungen bringen, während Forscher, Entwickler und die breitere Gesellschaft gemeinsam das Potenzial dieser transformativen Technologie erkunden und formen.

Kommentare (2)

Michael Schmidt

7. März 2024, 10:15Ausgezeichneter Artikel! Ich setze ChatGPT täglich in meiner Arbeit als Softwareentwickler ein und bin erstaunt, wie es meine Produktivität gesteigert hat. Besonders interessant fand ich Ihre Ausführungen zu den zukünftigen Entwicklungen in Richtung multimodaler Systeme.

Thomas Weber

8. März 2024, 15:40Danke für den informativen Artikel. Als Informatikstudent frage ich mich, inwieweit die ethischen Herausforderungen, insbesondere in Bezug auf Bias und Desinformation, in den kommenden Modellgenerationen adressiert werden können. Haben Sie Einblicke, welche konkreten Fortschritte in diesem Bereich gemacht werden?

Dr. Markus Weber

9. März 2024, 09:20Hallo Thomas, danke für deine Frage! Es gibt tatsächlich vielversprechende Ansätze in diesem Bereich. Forscher arbeiten an verbesserten Trainingsmethoden, die Bias explizit erkennen und reduzieren, sowie an Techniken zur Erkennung von KI-generierten Inhalten. Auch Regulierungsbehörden werden aktiver - der EU AI Act ist ein Beispiel dafür. In einem zukünftigen Artikel werde ich detaillierter auf diese Entwicklungen eingehen.

Hinterlassen Sie einen Kommentar